最新科研动态、科研成果与研究都是每一位学者较为关注的热点。今天小编为大家整理了清华大学、北京大学、中科大在计算机信息领域最新获取的成果展示。

01.清华大学发布基于元算子和动态编译的深度学习框架- Jittor

深度学习技术正广泛应用于人工智能的各个领域,如计算机视觉、机器翻译、自然语言处理、智能机器人等,取得了前所未有的突破。当前,一方面,随着深度学习新技术的出现、任务复杂度的提高,易于扩展同时保持高效的架构成为发展趋势;另一方面,我国人工智能产业发展迅速,急需构建自己的开源深度学习生态。

清华大学计算机系胡事民教授研究团队提出了一个全新的深度学习框架——计图(Jittor)。Jittor是一个采用元算子表达神经网络计算单元、完全基于动态编译(Just-in-Time)的深度学习框架。

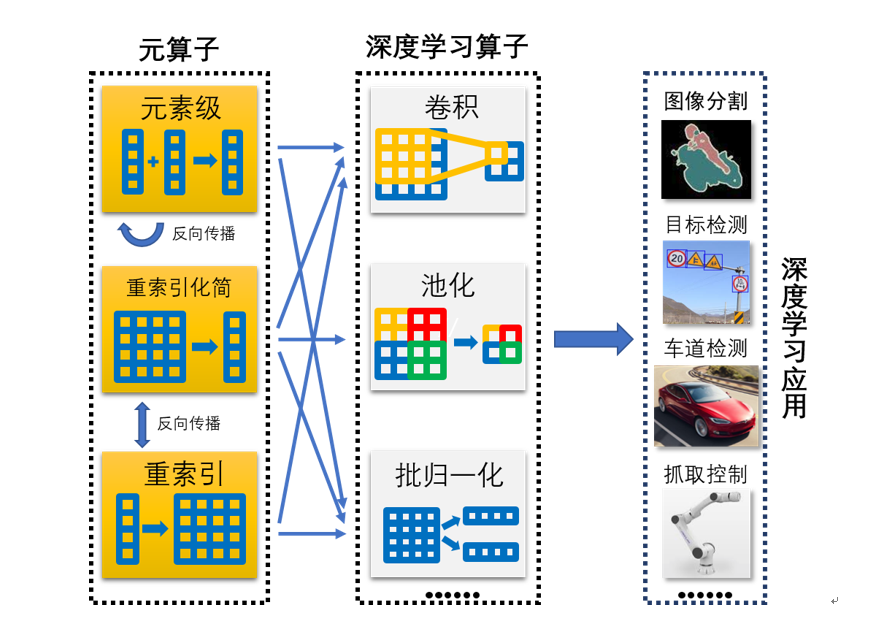

图1 “计图”通过元算子融合实现深度神经网络模型

深度学习采用的卷积神经网络是由算子(Operator)组成的一个计算网络。由于架构设计和不断扩充等原因,当前深度学习框架有多达2000种算子,系统复杂,优化和移植困难。Jittor则将算子运算进一步分解,形成了更加底层的三类20余种元算子闭包,目前神经网络常用算子均可以使用元算子的组合进行表达。面向未来深度学习框架的发展趋势,Jittor利用元算子组合表达的优势,提出统一计算图进行优化,并从底层开始设计了一个全新的动态编译架构。该架构支持多种编译器,实现了所有代码的即时编译和动态运行,确保了实现和优化分离,大幅提升了应用开发灵活性、可拓展性和可移植性。

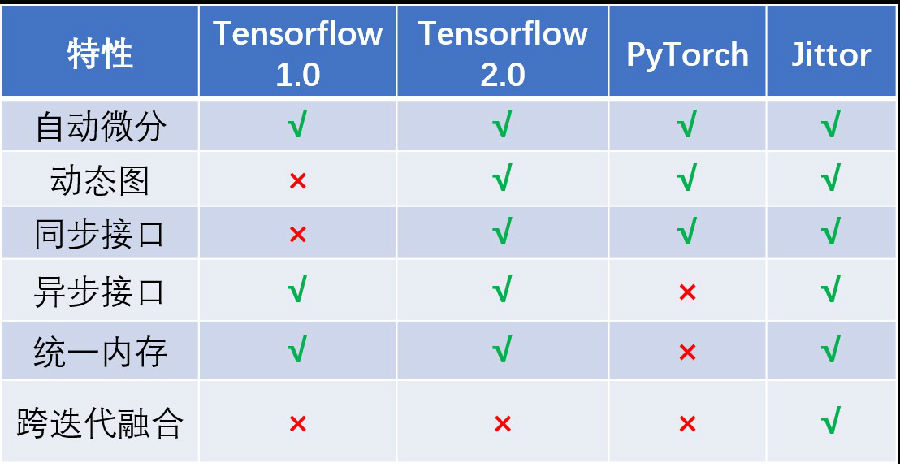

图2 “计图”与其他平台的计算图特性对比

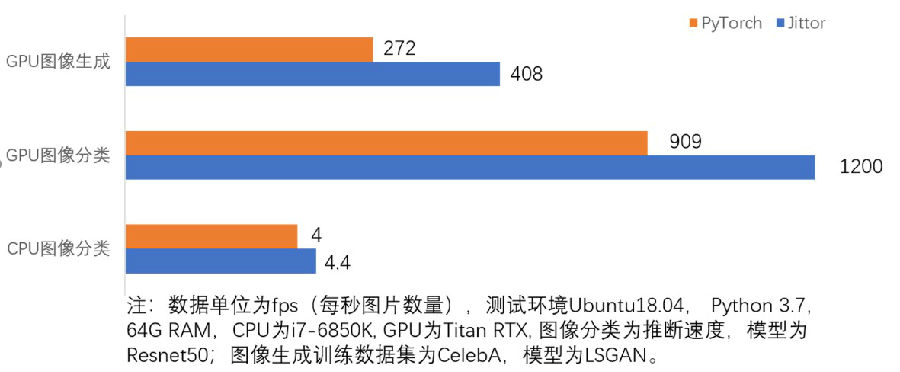

Jittor与国际主流平台相比,具有多项先进特性(图2)。目前ResNet、VGG、SSD、DeepLab、LSGAN等多个网络模型已经在Jittor平台实现,可供用户使用。与同类型框架相比,Jittor在收敛精度一致情况下,推理速度取得了10%-50%的性能提升(图3)。

图3 Jittor和PyTorch推理与训练速度对比

Jittor的研发得到了国家自然科学基金创新群体项目、北京信息科学与技术国家研究中心团队项目和清华-腾讯联合实验室项目的资助。期望Jittor能为学界和业界提供一个灵活高效的深度学习平台,促进人工智能的研究和应用,赋能人工智能产业。

了解更多信息,请访问“计图(Jittor)”官方网站:

https://cg.cs.tsinghua.edu.cn/jittor。02.北京大学-计算机科学技术系 高可信软件教育部重点实验室 许进团队生物计算机取得突破成果

生命体是一个以生物大分子为材料构成的人类已知的最智慧的信息处理“机器”。所以,人类近几十年来,意在用生物材料研发信息处理的计算机,称为生物计算机。当前的生物计算机主要集中于DNA计算机的理论、实现技术与方法展开研发。

DNA计算机目前的研究方向有两个:一个是以DNA分子作为“数据”,以生物酶或生化操作为信息处理的“工具”来研发DNA计算机,其功能类似于当今的电子计算机;另一类是以DNA为纳米材料,以DNA自组装技术为主要技术手段来构建纳米机器。例如构建纳米机器人来实现疾病诊断和治疗,快速实现纳米电路。近些年,北京大学计算机科学技术系高可信软件教育部重点实验室的许进团队在DNA计算机的上述两个方面均取得了突破性进展。

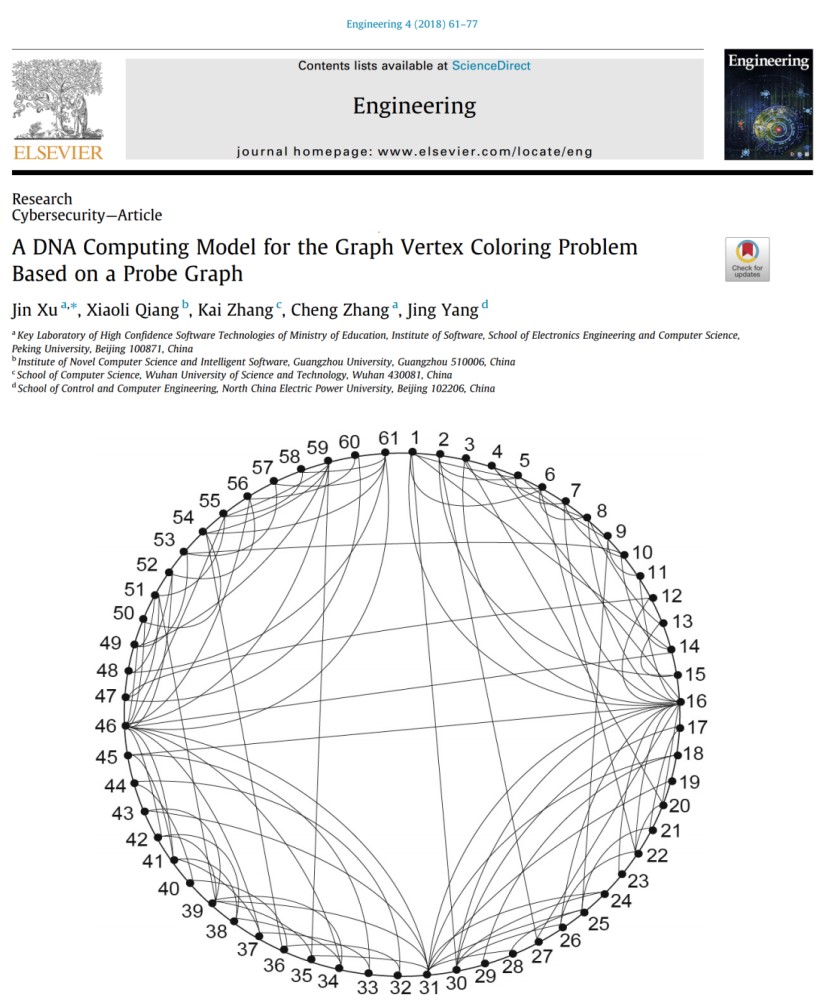

在DNA计算机领域,课题组针对典型的NP-完全问题——图着色问题的求解,相继提出了非枚举、并行、大规模DNA计算模型后,从理论上对并行DNA计算模型给予系统研究,研究成果《A DNA Computing Model for the Graph Vertex Coloring Problem Based on a Probe Graph》发表在领袖级期刊《Engineering》上。该成果包括在实验方面,实现人类非传统计算机最大规模问题的求解,其算法复杂度到达359;在理论方面,有机将DNA特性与数学模型相结合,整个计算模型中含4个并行部分。美国科学院院士Erik Winfree和美国加利福尼亚大学教授Richard Beigel评价为“你们突破性的成果振奋人心”。审稿专家称该成果是“继Adleman开创生物计算后最重要的突破”。

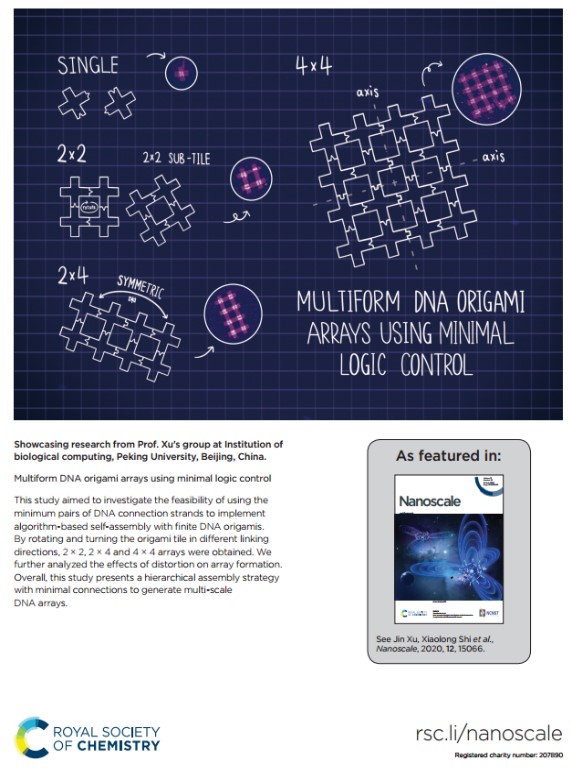

在DNA自组装方面,课题组设计了一种可复用的十字形DNA瓦片结构。DNA瓦片两两之间能任意拼接,构成大小可控的逻辑阵列。折纸结构上的沟道,为纳米电路的排布留下了布线空间。该方法大幅减少了所需DNA瓦片的数量,且降低了连接复杂度。相关成果以封面论文发表在2020年7月的国际著名期刊《Nanoscale》上,该成果的第一作者为许进的博士生陈从周,许进为通讯作者。

另外,许进团队课题组聚焦DNA计算理论和DNA分子机器,围绕生物计算、自组装等领域开展研究。设计了非枚举型的计算模型,可控DNA环阵列,相关成果在IEEE Trans等杂志等上发表,受到英国化学皇家学会的专题报道。

系列研究得到了科技部国家重点研发计划、国家自然科学基金重点项目、国家自然科学基金多项面上项目资助。

03. 中科大首次在“神威•太湖之光”超算上实现千万核心并行的第一性原理计算

在国家自然科学基金项目(批准号:21688102、21803066)的资助下,中国科学技术大学杨金龙院士、胡伟研究员和安虹教授团队合作,在第一性原理模拟大尺寸数万原子/分子固体体系领域,以低标度平面波高精度计算软件为基础,首次在“神威·太湖之光”国家超级计算无锡中心实现了千万核超大规模并行计算。该成果以“基于‘神威·太湖之光’的千万核超算计算机上实现数万原子的DGDFT高性能计算(High performance computing of DGDFT for tens of thousands of atoms using millions of cores on Sunway Taihu Light)”为题,于2020年6月23日在线发表于《科学通报》(Science Bulletin)上。

论文链接:https://www.sciencedirect.com/science/article/pii/S2095927320304230。

“神威·太湖之光”是世界第一台理论浮点计算能力达到十亿亿次量级的超级计算机系统。不同于国际通用的“CPU+加速器”超算系统结构,“神威·太湖之光”强大的理论浮点计算性能来自于40960个完全由我国自主设计的第二代申威26010众核处理器。相比于同时代的商用多核处理器,申威众核处理器擅长处理规则且易于并行的计算密集型任务,具有更大规模的多级并行计算单元和独特的片上存储结构,其上的并行算法设计和性能优化正面临着诸多挑战。为了充分、高效利用这台高性能超算,迫切需要在重大应用问题的驱动下发展其上的算法设计和优化方法,真正实现利用我国自主研发的高性能超算,解决未来基础科学及应用科学领域的重大难题。

针对以上算法设计的实际需求,中国科学技术大学超算应用团队、软件移植和性能优化团队,基础算法库开发团队以及国家超算中心硬件技术支持团队密切合作,将理论与计算化学的低标度理论算法与国产高性能并行计算软硬件的优势相结合,开发了低标度、低通讯,低内存、低访存的并行计算方法,实现了具有平面波精度的千万核超大规模高性能并行计算,充分发挥了国产神威·太湖之光超级计算机的强大计算能力。

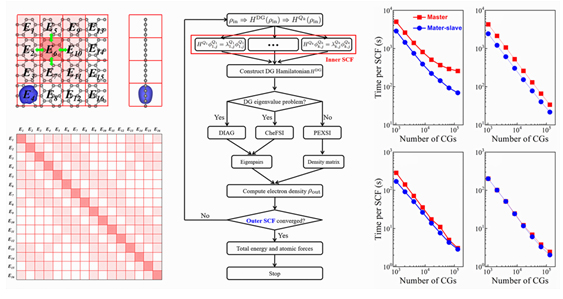

该团队以研究含有超万碳原子(11520碳原子)的二维金属石墨烯体系的电子结构为驱动,采用了间断有限元密度泛函理论(Discontinuous Galerkin Density Functional Theory,DGDFT)方法,该方法利用自洽场迭代过程中动态生成的自适应局域基函数来求解科恩-沈吕九(Kohn-Sham)方程,具有可媲美于平面波基组的高计算精度。该方法中的并行算法则采用两级并行化策略,用于处理并行计算中各种类型的数据分布、任务调度和数据通信方案等。基于主从核多线程异构并行和高性能计算函数库,首次在“神威·太湖之光”超级算系统完成了8519680个计算处理核(131072个核组)并行的超大规模第一性原理计算。此次计算中所模拟的体系大小(超万原子)比国际同等平面波精度的计算模拟软件提高了数百倍。

这一研究成果表明,借助当代最先进的计算方法和世界顶级高性能计算平台,大体系、长时间的高精度第一性原理材料模拟已成为现实。

上一篇

上一篇